Что такое объемный подход к измерению информации

Объемный подход к измерению информации

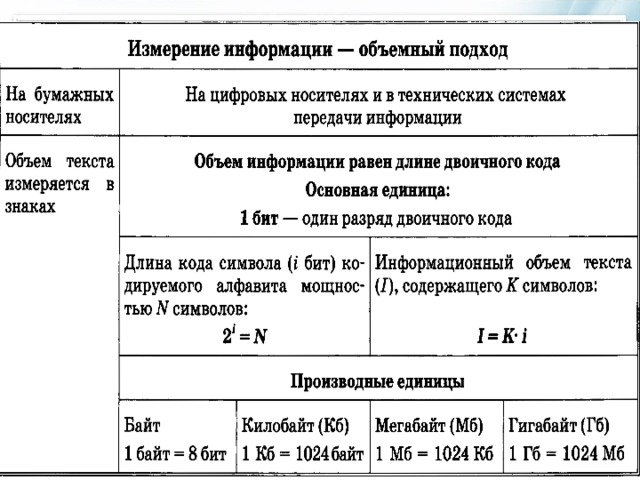

Объемный подход к измерению информации применяется в цифровых (компьютерных) системах хранения и передачи информации. В этих системах используется двоичный способ кодирования информации. При объемном подходе для определения количества информации имеет значение лишь размер (объем) хранимого и передаваемого кода. Объемный подход еще называют алфавитным подходом. Из курса информатики 8–9 классов вы знаете, что если с помощью i-разрядного двоичного кода можно закодировать алфавит, состоящий из N символов, то эти величины связаны между собой по формуле:

Число N называется мощностью алфавита. Например, если i = 2, то можно построить 4 двухразрядные комбинации из нулей и единиц, т. е. закодировать 4 символа. При i = 3 существует 8 трехразрядных комбинаций нулей и единиц (кодируется 8 символов):

Английский алфавит содержит 26 букв. Для записи текста нужны еще, как минимум, шесть символов: пробел, точка, запятая, вопросительный знак, восклицательный знак, тире. В сумме получается расширенный алфавит, мощностью в 32 символа.

Поскольку 2 5 =32, то все символы можно закодировать всевозможными пятиразрядными двоичными кодами от 00000 до 11111. Именно пятиразрядный код использовался в телеграфных аппаратах, появившихся еще в XIX веке. Телеграфный аппарат при вводе переводил английский текст в двоичный код, длина которого в 5 раз больше, чем длина исходного текста.

| В двоичном коде каждая двоичная цифра несет одну единицу информации, которая называется 1 бит. |

| Бит является основной единицей измерения информации. |

Длина двоичного кода, с помощью которого кодируется символ алфавита, называется информационным весом символа. В рассмотренном выше примере информационный вес символа расширенного английского алфавита оказался равным 5 битам.

Информационный объем текста складывается из информационных весов всех составляющих его символов. Например, английский текст из 1000 символов в телеграфном сообщении будет иметь информационный объем 5000 бит.

Алфавит русского языка включает 33 буквы. Если к нему добавить еще пробел и пять знаков препинания, то получится набор из 39 символов. Для его двоичного кодирования пятиразрядного кода уже не достаточно. Нужен, как минимум, 6-разрядный код. Поскольку 2 6 =64, то остается еще резерв для 25 символов (64-39=25). Его можно использовать для кодирования цифр, всевозможных скобок, знаков математических операций и других символов, встречающихся в русском тексте. Следовательно, информационный вес символов в расширенном русском алфавите будет равен 6 битам. А текст из 1000 символов будет иметь объем 6000 бит.

Если i- информационный вес символа алфавита, а К – число символов в тексте, записанном с помощью этого алфавита, то информационный объем текста (I) выражается формулой:

Идея измерения количества информации в сообщении через длину двоичного кода с этим сообщением принадлежит выдающемуся российскому математику Андрею Николаевичу Колмогорову. Согласно Колмогорову, количество информации, содержащееся в тексте, определяется минимально возможной длиной двоичного кода, необходимого для представления этого текста.

|

Для определения информационного веса символа полезно представлять себе ряд целых степеней двойки. Вот как он выглядит в диапазоне от 2 1 до 2 10 :

Информационный вес символа из алфавита мощности N определяется по ближайшему значению во второй строке таблицы, не меньшему, чем N. Соответствующее значение i в первой строке равно информационному весу символа.

Пример. Определим информационный вес символа из алфавита, включающего в себя все строчные и прописные русские буквы (66); цифры (10); знаки препинания, скобки, кавычки (10). Всего получается 76 символов.

Более крупной единицей измерения информации является байт: 1 байт = 8 бит.

Информационный объем текста в памяти компьютер, измеряется в байтах. При использовании восьмиразрядного кода он равен количеству символов в записи текста

Одна страница текста на листе формата А4 кегля 12 с одинарным интервалом между строками (см. пример выше) в компьютерном представлении будет иметь объем 4000 байтов, так как на ней помещается примерно 4000 знаков.

Помимо бита и байта, для измерения информации используются и более крупные единицы:

1Кб (килобайт) = 2 10 байт=1024 байта;

1Мб (мегабайт) = 2 10 Кб=1024 Кб;

1Гб (гигабайт) = 2 10 Мб=1024 Мб;

1Тб (терабайт) = 2 10 Гб=1024 Гб.

Объем той же страницы текста будет равным приблизительно 3,9Кб. А книга из 500 таких страниц займет в памяти компьютера примерно 1,9 Мб.

Объем любой информации, выраженный в битах, равен количеству двоичных разрядов в ее представлении в памяти компьютера

Подходы к измерению информации

В информатике используются различные подходы к измерению информации:

Алфавитный (кибернетический, объемный) подход к измерению информациине связывает кол-во информации с содержанием сообщения. Кол-во информации зависит от объема текста и мощности алфавита.

Алфавит – конечное множество различных знаков, символов, для которых определена операция конкатенации (приписывания, присоединения символа к символу или цепочке символов); с ее помощью по определенным правилам соединения символов и слов можно получать слова (цепочки знаков) и словосочетания (цепочки слов) в этом алфавите.

Конечная последовательность букв алфавита называется словом.

Длиной некоторого слова называется число составляющих его символов.

N при алфавитном подходе называют мощностью алфавита. Информационная ёмкость каждого знака зависит от количества знаков в алфавите. Следовательно, каждый из N символов несёт i бит информации.

Остаётся подсчитать количество символов в тексте сообщения k.

Алфавитный подход является объективным способом измерения информации и подходит для работы технических устройств.

Минимальная мощность алфавита, пригодного для передачи информации, равна 2. Такой алфавит называется двоичным алфавитом. Информационный вес символа в двоичном алфавите легко определить. Поскольку 2 i = 2, то i = 1 бит. Итак, один символ двоичного алфавита несет 1 бит информации.

Например, основная физическая единица длины — метр. Но существуют миллиметр, сантиметр, километр. Расстояния разного размера удобно выражать через разные единицы. Так же обстоит дело и с измерением информации.

1 бит — это исходная единица.

Пример: слово «мир» несет 24 бит информации.

Содержательный (энтропийный, вероятностный) подход к измерению информации. Этотподход основан на том, что факт получения информации всегда связан с уменьшением неопределенности (энтропии) системы. Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными. Если сообщение не информативно, то количество информации с точки зрения человека = 0.

Пример: вузовский учебник по высшей математике содержит знания, но они не доступны 1-класснику.

I = Hapr – Haps

гдеHapr – априорная энтропия о состоянии исследуемой системы или процесса;

Haps – апостериорная энтропия.

Апостериори (от лат. aposteriori – из последующего) – происходящее из опыта (испытания, измерения). Априори (от лат. apriori – из предшествующего) – понятие, характеризующее знание, предшествующее опыту (испытанию) и независимое от него.

В случае, когда в ходе испытания имевшаяся неопределенность снята (получен конкретный результат, то есть Haps = 0), количество полученной информации совпадает с первоначальной энтропией.

Так, американский инженер Р. Хартли (1928 г.) процесс получения информации рассматривает как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определяет как двоичный логарифм N.

| Формула Хартли: H= log2N. |

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле Хартли можно вычислить, какое количество информации для этого требуется: I = log2100 » 6,644. То есть сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единиц информации.

Приведем другие примеры равновероятных сообщений:

1. при бросании монеты: «выпала решка», «выпал орел»;

2. на странице книги: «количество букв чётное», «количество букв нечётное».

Определим теперь, являются ли равновероятными сообщения «первой выйдет из дверей здания женщина» и «первым выйдет из дверей здания мужчина». Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

|

Задача1: Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых, 25красных, 25 синих шариков

1) всего шаров 50+25+25=100

2) вероятности шаров 50/100=1/2, 25/100=1/4, 25/100=1/4

Количество информации достигает max значения, если события равновероятны, поэтому количество информации можно расcчитать по формуле

Задача2 : В корзине лежит 16 шаров разного цвета. Сколько информации несет сообщение, что достали белый шар?

т.к. N = 16 шаров, то I = log2 N = log2 16 = 4 бит.

Алгоритмическое измерение информации [2]

Был предложен в 1965 году академиком А.Н. Колмогоровым. Алгоритмическая сложность некоторой последовательности данных определяется как минимальная длина вычислительного алгоритма, который мог бы воспроизвести заданную последовательность.

Например: слово 000000 – простое, слово 01010101 – более сложное, а слово, в котором 0 и 1 выбираются экспериментально при бросании монеты (1 – орел, 0 – решка), еще сложнее.

Компьютерная программа, печатающая первое слово, совсем простая; для получение второго слова нужна более сложная программа, которая будет печатать символ, противоположный предыдущему. Случайная последовательность, не обладающая никакими закономерностями, может быть напечатана программой, в которой каждый очередной символ будет печататься отдельным оператором. То есть длина такой программы будет близка к длине самой последовательности. Следовательно, любому сообщению можно приписать количественную характеристику, отражающую размер программы, которая позволяет ее воспроизвести.

Измерение информации. Объёмный подход

Описание разработки

При работе с информацией важно возникают вопросы связанные с измерением информации:

— достаточно ли места на носителе, чтобы разместить нужную информацию?

— сколько времени понадобиться, чтобы передать её по имеющемуся каналу связи?

Величина, которая нас интересует в этих случаях, называется ОБЪЁМОМ ИНФОРМАЦИИ.

Когда говорят об объёме, то имеют ввиду размер текста в том алфавите. С помощью которого эта информация представлена.

Количество страниц не является универсальным измерением информации.

Объем информации, заключённый в тексте, разумнее измерять количеством знаков этого текста.

Объёмный способ измерения информации называют АЛФАВИТНЫМ ПОДХОДОМ.

Содержимое разработки

§3. Измерение информации. Объёмный подход.

Рыженко Е. В. МБОУ г. Астрахани » СОШ №64″

При работе с информацией важно возникают вопросы связанные с измерением информации:

Величина, которая нас интересует в этих случаях, называется ОБЪЁМОМ ИНФОРМАЦИИ.

Объём информации не связан с её содержанием.

Когда говорят об объёме, то имеют ввиду размер текста в том алфавите. С помощью которого эта информация представлена.

детскую книгу из нескольких десятков страниц можно перепечатать мелким шрифтом и без иллюстраций на 2-3 страницы.

Количество страниц не является универсальным измерением информации.

количество страниц определяет расход бумаги, а не объём информации.

объем информации, заключённый в тексте, разумнее измерять количеством знаков этого текста.

например, журналисту может быть дано ограничение на объём статьи в 40 000 знаков.

объёмный способ измерения информации называют

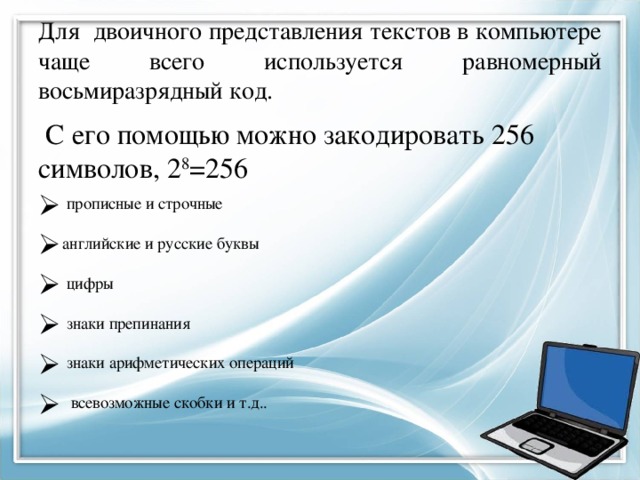

Для двоичного представления текстов в компьютере чаще всего используется равномерный восьмиразрядный код.

С его помощью можно закодировать 256 символов, 2 8 =256

При двоичном кодировании объём информации, выраженный в битах, равен длине двоичного кода, в котором информация представлена.

Информационный объём текста в память компьютера измеряется в байтах.

Он равен количеству знаков а записи текста.

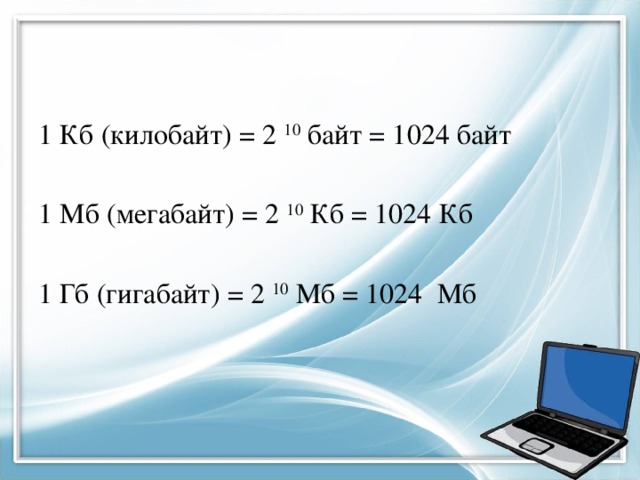

1 Кб (килобайт) = 2 10 байт = 1024 байт

1 Мб (мегабайт) = 2 10 Кб = 1024 Кб

1 Гб (гигабайт) = 2 10 Мб = 1024 Мб

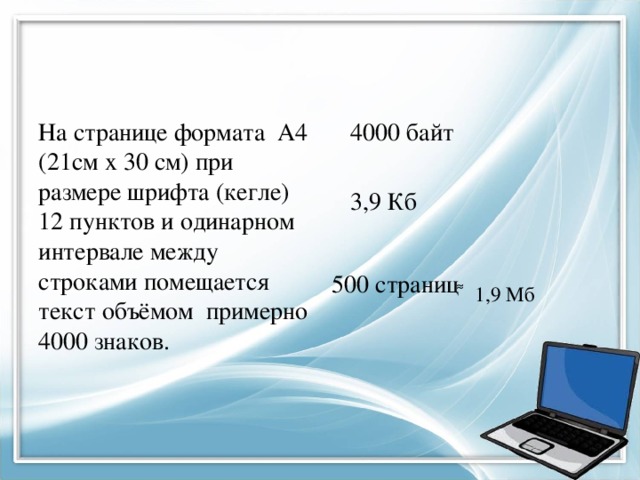

На странице формата А4 (21см х 30 см) при размере шрифта (кегле) 12 пунктов и одинарном интервале между строками помещается текст объёмом примерно 4000 знаков.

500 страниц ͌ 1,9 Мб

kpet-ks.ru

Компьютерные сети. г.Котово

Подходы к измерению количества информации

1.Алфавитный (объёмный) подход к измерению информации

Теория:

N=2 i

Для измерения информации используются и более крупные единицы:

2.Содержательный поход

В содержательном подходе количество информации, заключенное в сообщении, определяется объемом знаний, который это сообщение несет получающему его человеку.

Вспомним, что с «человеческой» точки зрения информация — это знания, которые мы получаем из внешнего мира. Количество информации, заключенное в сообщении, должно быть тем больше, чем больше оно пополняет наши знания.

Вы уже знаете, что за единицу измерения информации принимается 1 бит.

1 бит — минимальная единица измерения количества информации.

Проблема измерения информации исследована в теории информации, основатель которой — Клод Шеннон.

В теории информации для бита дается следующее определение:

Сообщение, уменьшающее неопределенность знания в два раза, несет 1 бит информации.

Что такое неопределенность знания, поясним на примерах.

Допустим, вы бросаете монету, загадывая, что выпадет: орел или решка. Есть всего два возможных результата бросания монеты. Причем ни один из этих результатов не имеет преимущества перед другим. В таком случае говорят, что они равновероятны.

В случае с монетой перед ее подбрасыванием неопределенность знания о результате равна двум.

Игральный же кубик с шестью гранями может с равной вероятностью упасть на любую из них. Значит, неопределенность знания о результате бросания кубика равна шести.

Еще пример: спортсмены-лыжники перед забегом путем жеребьевки определяют свои порядковые номера на старте. Допустим, что имеется100 участников соревнований, тогда неопределенность знания спортсмена о своем номере до жеребьевки равна 100.

Следовательно, можно сказать так:

Неопределенность знания о результате некоторого события (бросание монеты или игрального кубика, вытаскивание жребия и др.) — это количество возможных результатов.

Вернемся к примеру с монетой. После того как вы бросили монету и посмотрели на нее, вы получили зрительное сообщение, что выпал, например, орел. Определился один из двух возможных результатов. Неопределенность знания уменьшилась в два раза: было два варианта, остался один. Значит, узнав результат бросания монеты, вы получили 1 бит информации.

Сообщение об одном из двух равновероятных результатов некоторого события несет 1 бит информации.

Пусть в некотором сообщении содержатся сведения о том, что произошло одно из Nравновероятных событий.

Тогда количество информацииi, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, можно определить из формулы Хартли:

Данная формула является показательным уравнением относительно неизвестногоi.

Из математики известно, что решение такого уравнения имеет вид:

i=log2N– логарифм N по основанию 2.

Если N равно целой степени двойки (2,4,8,16и т. д.), то такое уравнение можно решить «в уме».

Шахматная доска состоит из64 полей:8 столбцов на 8 строк.

Какое количество бит несет сообщение о выборе одного шахматного поля?

Решение.

Поскольку выбор любой из 64 клеток равновероятен, то количество бит находится из формулы:

2 i =64,

i=log264=6, так как 2 6 =64.

Следовательно, i=6 бит.

В противном случае количество информации становится нецелой величиной, и для решения задачи придется воспользоваться таблицей двоичных логарифмов.

Также, если N не является целой степенью 2, то можно выполнить округление i в большую сторону. При решении задач в таком случаеi можно найти какlog2K, гдеK— ближайшая к Nстепень двойки, такая, что K>N.

При игре в кости используется кубик с шестью гранями.

Сколько битов информации получает игрок при каждом бросании кубика?

Решение.

Выпадение каждой грани кубика равновероятно. Поэтому количество информации от одного результата бросания находится из уравнения:2 i =6.

Решение этого уравнения: i=log26.

Из таблицы двоичных логарифмов следует (с точностью до3-х знаков после запятой):

i=2,585бита.

Данную задачу также можно решить округлением i в большую сторону: 2 i =6 3 ,i=3 бита.

3.Вероятностный подход

В реальной жизни существует множество ситуаций с различными вероятностями. Например, если у монеты одна сторона тяжелей другой, то при ее бросании вероятность выпадения «орла» и «решки» будет различной.

Сначала разберемся с понятием «вероятность». Введем следующие понятия:

испытание – любой эксперимент;

единичное испытание – испытание, в котором совершается одно действие с одним предметом (например, подбрасывается монетка, или из корзины извлекается шар);

исходы испытаний – результаты испытания (например, при подбрасывании монеты выпал «орел», или из корзины извлекли белый шар);

множество исходов испытания – множество всех возможных исходов испытания;

случайное событие – событие, которое может произойти или не произойти (например, выигрыш билета в лотерее, извлечение карты определенной масти из колоды карт).

Вероятностью случайного события (p) называется отношение числа благоприятствующих событию исходов (m) к общему числу исходов (n):

Заметим, что вероятность случайного события может изменяться от 0 до 1.

Пример:

В беспроигрышной лотерее разыгрывается 3 книги, 2 альбома, 10 наборов маркеров, 10 блокнотов.

Какова вероятность выиграть книгу?

Общее число исходов 2+3+10+10=25; число благоприятствующих исходу событий равно 3. Вероятность выигрыша книги вычисляется по формуле: p=3/25=0,12.

Заметим, что во многих случаях события происходят с разной вероятностью, а значит формула N=2 i не всегда применима.

Вероятностный подход предполагает, что возможные события имеют различные вероятности реализации.

В этом случае, зная вероятность (p) событий, можно определить количество информации (i) в сообщении о каждом из них из формулы:

Количество информации будет определяться по формуле Шеннона, предложенной им в 1948 г. для различных вероятностных событий:

где I – количество информации;

N – количество возможных событий;

pi – вероятность i-го события.

Качественная связь между вероятностью события и количеством информации в сообщении состоит в следующем: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

В корзине лежат 8 черных шаров и 24 белых. Сколько бит информации несет сообщение о том, что достали черный шар?

Решение. Общее число исходов: 8+24=32, число благоприятствующих исходу событий равно 8.

Вероятность выбора черного шара определяется как p=8/32=1/4=0,25.

Количество информации вычисляем из соотношения 2 i =1/0,25=1: (1/4)=4,

Пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий равны:

Тогда количество информации, которое будет получено после реализации одного из событий, можно вычислить по формуле Шеннона: