Что такое неравновероятные события

Вероятностный подход к оценке количества информации. Формула Шеннона

Вы будете перенаправлены на Автор24

В основе нашего мира лежат три составляющие: вещество, энергия и информация. Как много в мире вещества, энергии и информации? Можно ли их измерить и как именно? Нам известны способы измерения количества вещества и энергии. Но как быть с информацией? Можно ли ее измерить?

Ранее уже отмечалось, что существует несколько подходов к оценке количества информации. Сейчас мы более подробно остановимся на одном из них.

Любое сообщение будет являться информативным, если оно пополняет знания человека, т.е. уменьшает неопределенность его знаний.

Равновероятные события

Например, при подбрасывании монеты мы пытаемся угадать, какой стороной она упадет. Возможен один из вариантов исхода: монета окажется в положении «орел» или «решка». Каждое из этих двух событий окажется равновероятным, т. е. ни одно из них не имеет преимущества перед другим. Перед подбрасыванием монеты никто не может знать, как она упадет, т.е. существует неопределенность знания. После же наступления события, наоборот, присутствует полная определенность, так как бросающий получает зрительное сообщение о положении монеты, которое, в свою очередь, уменьшает неопределенность его знания в два раза, поскольку из двух равновероятных событий произошло одно.

Другим примером является ситуация с шестигранным кубиком, т.е. перед броском никто не может знать, какой стороной он упадет. В данном случае присутствует возможность получить один результат из шести равновероятных. Таким образом, до броска неопределенность знаний бросающего будет равна 6, после же броска, она уменьшится ровно в 6 раз, поскольку именно 6 равновероятных событий может произойти.

Рассмотрим пример, где для экзамена приготовили 40 билетов. Вероятность событий, которые произойдут при вытягивании билета, будет равна 40. Причем эти события будут равновероятны. При этом неопределенность знаний студента перед выбором билета, будет равна 40. Соответственно неопределенность знания после того как студент взял билет уменьшится в 40 раз. Зададимся вопросом, зависит ли этот показатель от номера вытянутого билета. Нет, поскольку события равновероятны.

Готовые работы на аналогичную тему

Проанализировав все рассмотренные выше примеры, можно прийти к выводу, что чем больше исходное число возможных равновероятных событий, тем в большее количество раз уменьшается неопределенность знаний, и тем большее количество информации будет содержаться в сообщении о результатах опыта.

Неравновероятные события

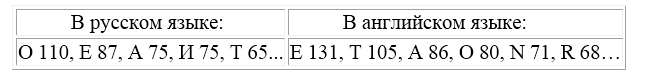

Помимо этого, вероятность появления отдельных букв будет зависеть от того, какие буквы используются перед ними. Так, в русском языке после гласной никогда не может стоять мягкий знак, а также в словах не используются четыре гласные подряд и т.д. Разговорные языки имеют, как правило, свои особенности и закономерности. Именно поэтому количество информации, содержащееся в сообщениях любого разговорного языка, неприемлемо оценивать с помощью формулы Хартли, которая используется в алфавитном подходе к оценке информации и характерна для примеров с равновероятными событиями (примеры с монетой и кубиком).

Как определить, какое количество информации содержит, например, текст романа «Война и мир», или фрески и полотна великих итальянских художников, или генетический код человека? Ответы на эти вопросы и подобные им науке пока не известны и, по всей вероятности, еще не скоро будут известны. Однако всех интересует, возможно ли объективно оценить количество информации? К задаче подобного рода можно отнести следующий пример.

Как выяснить, являются ли равновероятными сообщения «первой выйдет из здания женщина» и «первым выйдет из здания мужчина»? Однозначного ответа на этот вопрос нет. Все будет зависеть от того, о каком именно здании идет речь. Если это, например, здание гинекологической клиники, то вероятность выйти первой у женщины очень высока, если это военная казарма, то вероятность выйти первым для мужчины будет выше, чем для женщины, а вот если это здание кинотеатра, то вероятности выйти первыми для мужчины и женщины будут одинаковыми.

Оценка количества информации. Формула Шеннона

Для решения задач подобного рода используется общая оценка количества информации, предложенная американским учёным Клодом Шенноном в 1948г. Созданная им формула определения количества информации способна учитывать возможную неодинаковую вероятность сообщений, содержащихся в наборе. Шеннон при создании формулы использовал применяемую в математике и гидродинамике вероятностную меру неопределенности (называемую энтропией) для того, чтобы в полной мере оценить состояние изучаемой системы и получить максимально возможную информацию о протекающих в этой системе процессах. Эта оценка количества информации, по существу, является вероятностной мерой, и, как оценка неопределенности, она отражает способность какого-либо источника проявлять все новые и новые состояния и таким образом отдавать информацию.

Шеннон определил энтропию как среднюю логарифмическую функцию множества вероятностей возможных состояний системы (возможных исходов опыта). Для расчета энтропии Шеннон предложил следующее уравнение:

Тогда количество информации, полученное в результате опыта, будет не что иное, как разность между энтропией системы до ($H_0$) и после ($H_1$) опыта:

причем если неопределенность в результате опыта полностью исключается, то имеем:

Рассмотрим пример, подтверждающий использование данной теории Шеннона на практике.

Решение. События улова пескаря или окуня не являются равновероятными, поскольку окуней в озере обитает намного меньше, чем пескарей.

Общее количество пескарей и окуней, обитающих в озере:

Определим вероятность улова пескаря:

Определим вероятность улова окуня:

Количество информации, содержащейся в сообщении об улове пескаря:

$I_1 = log_2(\frac<1><0,75>) » 0,43$ бит,

Количество информации, содержащейся в сообщении об улове окуня:

Количество информации, содержащейся в сообщении об улове рыбы (карася или окуня) рассчитывается по формуле Шеннона:

Получи деньги за свои студенческие работы

Курсовые, рефераты или другие работы

Автор этой статьи Дата написания статьи: 12 04 2016

Измерение информации. Содержательный подход

С позиции содержательного подхода к измерению информации решается вопрос о количестве информации в сообщении, получаемом человеком. Рассматривается следующая ситуация:

1) человек получает сообщение о некотором событии; при этом заранее известна неопределенность знания человека об ожидаемом событии. Неопределенность знания может быть выражена либо числом возможных вариантов события, либо вероятностью ожидаемых вариантов события;

2) в результате получения сообщения неопределенность знания снимается: из некоторого возможного количества вариантов оказался выбранным один;

3) по формуле вычисляется количество информации в полученном сообщении, выраженное в битах.

Формула, используемая для вычисления количества информации, зависит от ситуаций, которых может быть две:

1. Все возможные варианты события равновероятны. Их число конечно и равно N.

2. Вероятности (p) возможных вариантов события разные и они заранее известны:

Равновероятные события. Если обозначить буквой i количество информации в сообщении о том, что произошло одно из N равновероятных событий, то величины i и N связаны между собой формулой Хартли:

Величина i измеряется в битах. Отсюда следует вывод:

1 бит — это количество информации в сообщении об одном из двух равновероятных событий.

Формула Хартли — это показательное уравнение. Если i — неизвестная величина, то решением уравнения (1) будет:

Формулы (1) и (2) тождественны друг другу. Иногда в литературе формулой Хартли называют (2).

Пример 1. Сколько информации содержит сообщение о том, что из колоды карт достали даму пик?

В колоде 32 карты. В перемешанной колоде выпадение любой карты — равновероятные события. Если i — количество информации в сообщении о том, что выпала конкретная карта (например, дама пик), то из уравнения Хартли:

Пример 2. Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

Считая выпадение любой грани событием равновероятным, запишем формулу Хартли: 2 i = 6. Отсюда: i = log26 = 2,58496 бит.

Неравновероятные события (вероятностный подход)

Если вероятность некоторого события равна p, а i (бит) — это количество информации в сообщении о том, что произошло это событие, то данные величины связаны между собой формулой:

Решая показательное уравнение (3) относительно i, получаем:

Формула (4) была предложена К.Шенноном, поэтому ее называют формулой Шеннона.

Методические рекомендации

Обсуждение связи между количеством информации в сообщении и его содержанием может происходить на разных уровнях глубины.

Качественный подход

Качественный подход, который может использоваться на уровне пропедевтики базового курса информатики (5–7-е классы) или в базовом курсе (8–9-е классы).

На данном уровне изучения обсуждается следующая цепочка понятий: информация — сообщение — информативность сообщения.

Исходная посылка: информация — это знания людей, получаемые ими из различных сообщений. Следующий вопрос: что такое сообщение? Сообщение — это информационный поток (поток данных), который в процессе передачи информации поступает к принимающему его субъекту. Сообщение — это и речь, которую мы слушаем (радиосообщение, объяснение учителя), и воспринимаемые нами зрительные образы (фильм по телевизору, сигнал светофора), и текст книги, которую мы читаем, и т.д.

Вопрос об информативности сообщения следует обсуждать на примерах, предлагаемых учителем и учениками. Правило: информативным назовем сообщение, которое пополняет знания человека, т.е. несет для него информацию. Для разных людей одно и то же сообщение с точки зрения его информативности может быть разным. Если сведения “старые”, т.е. человек это уже знает, или содержание сообщения непонятно человеку, то для него это сообщение неинформативно. Информативно то сообщение, которое содержит новые и понятные сведения.

Примеры неинформативных сообщений для ученика 8-го класса:

1)“Столица Франции — Париж” (не новое);

2) “Коллоидная химия изучает дисперсионные состояния систем, обладающих высокой степенью раздробленности” (не понятное).

Пример информативного сообщения (для тех, кто этого не знал): “Эйфелева башня имеет высоту 300 метров и вес 9000 тонн”.

Введение понятия “информативность сообщения” является первым подходом к изучению вопроса об измерении информации в рамках содержательной концепции. Если сообщение неинформативно для человека, то количество информации в нем, с точки зрения этого человека, равно нулю. Количество информации в информативном сообщении больше нуля.

Количественный подход в приближении равновероятности

Данный подход может изучаться либо в углубленном варианте базового курса в основной школе, либо при изучении информатики в 10–11-х классах на базовом уровне.

Рассматривается следующая цепочка понятий: равновероятные события — неопределенность знаний — бит как единица измерения информации — формула Хартли — решение показательного уравнения для N равного целым степеням двойки.

Раскрывая понятие равновероятности, следует отталкиваться от интуитивного представления детей, подкрепив его примерами. События равновероятны, если ни одно из них не имеет преимущества перед другими.

Введя частное определение бита, которое было дано выше, затем его следует обобщить:

Сообщение, уменьшающее неопределенность знаний в 2 раза, несет 1 бит информации.

Это определение подкрепляется примерами сообщений об одном событии из четырех (2 бита), из восьми (3 бита) и т.д.

Формула Хартли (1) является частным случаем формулы (3). Если имеется N равновероятных событий (результат бросания монеты, игрального кубика и т.п.), то вероятность каждого возможного варианта равна p = 1/N. Подставив в (3), снова получим формулу Хартли: 2 i = N. Если бы в примере 3 автобусы № 5 и № 7 приходили бы к остановке из 100 раз каждый по 50, то вероятность появления каждого из них была бы равна 1/2. Следовательно, количество информации в сообщении о приходе каждого автобуса равно i = log22 = 1 биту. Пришли к известному варианту информативности сообщения об одном из двух равновероятных событий.

Пример 4. Рассмотрим другой вариант задачи об автобусах. На остановке останавливаются автобусы № 5 и № 7. Сообщение о том, что к остановке подошел автобус № 5, несет 4 бита информации. Вероятность появления на остановке автобуса с № 7 в два раза меньше, чем вероятность появления автобуса № 5. Сколько бит информации несет сообщение о появлении на остановке автобуса № 7?

Запишем условие задачи в следующем виде:

Вспомним связь между вероятностью и количеством информации: 2 i = 1/p

Подставляя в равенство из условия задачи, получим:

Из полученного результата следует вывод: уменьшение вероятности события в 2 раза увеличивает информативность сообщения о нем на 1 бит. Очевидно и обратное правило: увеличение вероятности события в 2 раза уменьшает информативность сообщения о нем на 1 бит. Зная эти правила, предыдущую задачу можно было решить “в уме”.

Теория вероятностей, формулы и примеры

Тема непростая, но если вы собираетесь поступать на факультет, где нужны базовые знания высшей математики, освоить материал — must have. Тем более, все формулы по теории вероятности пригодятся не только в универе, но и при решении 4 задания на ЕГЭ. Начнем!

Статья находится на проверке у методистов Skysmart.

Если вы заметили ошибку, сообщите об этом в онлайн-чат

(в правом нижнем углу экрана).

Основные понятия

Французские математики Блез Паскаль и Пьер Ферма анализировали азартные игры и исследовали прогнозы выигрыша. Тогда они заметили первые закономерности случайных событий на примере бросания костей и сформулировали теорию вероятностей.

Когда мы кидаем монетку, то не можем точно сказать, что выпадет: орел или решка.

Но если подкидывать монету много раз — окажется, что каждая сторона выпадает примерно равное количество раз. Из чего можно сформулировать вероятность: 50% на 50%, что выпадет «орел» или «решка».

Теория вероятностей — это раздел математики, который изучает закономерности случайных явлений: случайные события, случайные величины, их свойства и операции над ними.

Вероятность — это степень возможности, что какое-то событие произойдет. Если у нас больше оснований полагать, что что-то скорее произойдет, чем нет — такое событие называют вероятным.

Ну, скажем, смотрим на тучи и понимаем, что дождь — вполне себе вероятное событие. А если светит яркое солнце, то дождь — маловероятное или невероятное событие.

Случайная величина — это величина, которая в результате испытания может принять то или иное значение, причем неизвестно заранее, какое именно. Случайные величины можно разделить на две категории:

Вероятностное пространство — это математическая модель случайного эксперимента (опыта). Вероятностное пространство содержит в себе всю информацию о свойствах случайного эксперимента, которая нужна, чтобы проанализировать его через теорию вероятностей.

Формулы по теории вероятности

Теория вероятности изучает события и их вероятности. Если событие сложное, то его можно разбить на простые составные части — так легче и быстрее найти их вероятности. Рассмотрим основные формулы теории вероятности.

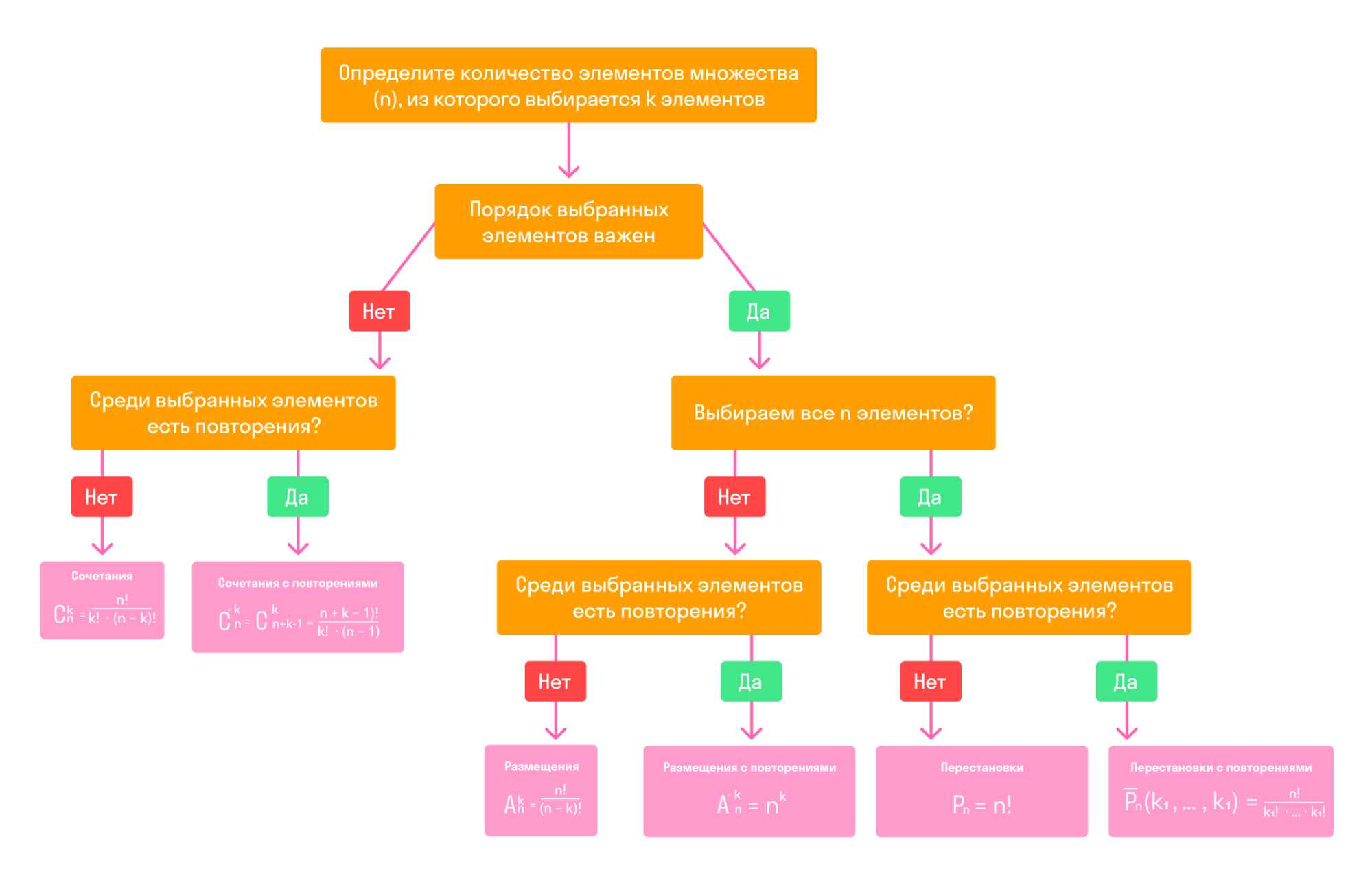

Случайные события. Основные формулы комбинаторики

Классическое определение вероятности

Вероятностью события A в некотором испытании называют отношение:

P (A) = m/n, где n — общее число всех равновозможных, элементарных исходов этого испытания, а m — количество элементарных исходов, благоприятствующих событию A

Таким образом, вероятность любого события удовлетворяет двойному неравенству:

Пример 1. В пакете 15 конфет: 5 с молочным шоколадом и 10 — с горьким. Какова вероятность вынуть из пакета конфету с белым шоколадом?

Так как в пакете нет конфет с белым шоколадом, то m = 0, n = 15. Следовательно, искомая вероятность равна нулю:

Неприятная новость для любителей белого шоколада: в этом примере событие «вынуть конфету с белым шоколадом» — невозможное.

Пример 2. Из колоды в 36 карт вынули одну карту. Какова вероятность появления карты червовой масти?

Количество элементарных исходов, то есть количество карт равно 36 (n). Число случаев, благоприятствующих появлению карты червовой масти (А) равно 9 (m).

Геометрическое определение вероятности

Геометрическая вероятность события А определяется отношением:

P(A)= m(A)/m(G), где m(G) и m(A) — геометрические меры (длины, площади или объемы) всего пространства элементарных исходов G и события А соответственно

Чаще всего, в одномерном случае речь идет о длинах отрезков, в двумерном — о площадях фигур, а в трехмерном — об объемах тел.

Пример. Какова вероятность встречи с другом, если вы договорились встретиться в парке в промежутке с 12.00 до 13.00 и ждете друг друга 5 минут?

У нас есть отличные курсы по математике для учеников с 1 по 11 классы — приглашаем на вводный урок!

Сложение и умножение вероятностей

Теорема о сложении вероятностей звучит так: вероятность появления одного из двух несовместных событий равна сумме вероятностей этих событий:

P(A + B) = P(A) + P(B)

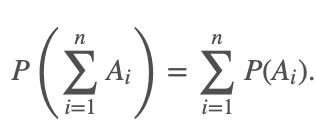

Эта теорема справедлива для любого числа несовместных событий:

Если случайные события A1, A2. An образуют полную группу несовместных событий, то справедливо равенство:

Произведением событий А и В называется событие АВ, которое наступает тогда, когда наступают оба события: А и В одновременно. Случайные события А и B называются совместными, если при данном испытании могут произойти оба эти события.

Вторая теорема о сложении вероятностей: вероятность суммы совместных событий вычисляется по формуле:

P(A + B) = P(A) + P(B) − P(AB)

События событий А и В называются независимыми, если появление одного из них не меняет вероятности появления другого. Событие А называется зависимым от события В, если вероятность события А меняется в зависимости от того, произошло событие В или нет.

Теорема об умножении вероятностей: вероятность произведения независимых событий А и В вычисляется по формуле:

P(AB) = P(A) * P(B)

Пример. Студент разыскивает нужную ему формулу в трех справочниках. Вероятности того, что формула содержится в первом, втором и третьем справочниках равны 0,6; 0,7 и 0,8.

Найдем вероятности того, что формула содержится:

А — формула содержится в первом справочнике;

В — формула содержится во втором справочнике;

С — формула содержится в третьем справочнике.

Воспользуемся теоремами сложения и умножения вероятностей.

Ответ: 1 — 0,188; 2 — 0,452; 3 — 0,336.

Формула полной вероятности и формула Байеса

|

По теореме умножения вероятностей:

Аналогично, для остальных гипотез:

Эта формула называется формулой Байеса. Вероятности гипотез называются апостериорными вероятностями, тогда как — априорными вероятностями.

Пример. Одного из трех стрелков вызывают на линию огня, он производит два выстрела. Вероятность попадания в мишень при одном выстреле для первого стрелка равна 0,3, для второго — 0,5; для третьего — 0,8. Мишень не поражена. Найти вероятность того, что выстрелы произведены первым стрелком.

Формула Бернулли

При решении вероятностных задач часто бывает, что одно и тоже испытание повторяется многократно, и исход каждого испытания независит от исходов других. Такой эксперимент называют схемой повторных независимых испытаний или схемой Бернулли.

Примеры повторных испытаний:

Итак, пусть в результате испытания возможны два исхода: либо появится событие А, либо противоположное ему событие. Проведем n испытаний Бернулли. Это означает, что все n испытаний независимы. А вероятность появления события А в каждом случае постоянна и не изменяется от испытания к испытанию.

Биномиальное распределение — распределение числа успехов (появлений события).

Пример. Среди видео, которые снимает блогер, бывает в среднем 4% некачественных: то свет плохой, то звук пропал, то ракурс не самый удачный. Найдем вероятность того, что среди 30 видео два будут нестандартными.

Опыт заключается в проверке каждого из 30 видео на качество. Событие А — это какая-то неудача (свет, ракурс, звук), его вероятность p = 0,04, тогда q = 0,96. Отсюда по формуле Бернулли можно найти ответ:

Ответ: вероятность плохого видео приблизительно 0,202. Блогер молодец🙂

Наивероятнейшее число успехов

Биномиальное распределение ( по схеме Бернулли) помогает узнать, какое число появлений события А наиболее вероятно. Формула для наиболее вероятного числа успехов k (появлений события) выглядит так:

Пример. В очень большом секретном чатике сидит 730 человек. Вероятность того, что день рождения наугад взятого участника чата приходится на определенный день года — равна 1/365 для каждого из 365 дней. Найдем наиболее вероятное число счастливчиков, которые родились 1 января.

Формула Пуассона

При большом числе испытаний n и малой вероятности р формулой Бернулли пользоваться неудобно. Например, 0.97 999 вычислить весьма затруднительно.

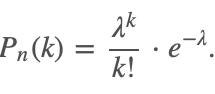

В этом случае для вычисления вероятности того, что в n испытаниях событие произойдет k раз, используют формулу Пуассона:

|

Здесь λ = np обозначает среднее число появлений события в n испытаниях.

Эта формула дает удовлетворительное приближение для p ≤ 0,1 и np ≤10.

События, для которых применима формула Пуассона, называют редкими, так как вероятность, что они произойдут — очень мала (обычно порядка 0,001-0,0001).

При больших np рекомендуют применять формулы Лапласа, которую рассмотрим чуть позже.

Пример. В айфоне 1000 разных элементов, которые работают независимо друг от друга. Вероятность отказа любого элемента в течении времени Т равна 0,002. Найти вероятность того, что за время Т откажут ровно три элемента.

P1000(3) = λ 3 /3! * e −λ = 2 3 /3! * e −2 ≈ 0,18.

Ответ: ориентировочно 0,18.

Теоремы Муавра-Лапласа

Кроме того, пусть Pn(k1;k2) — вероятность того, что число появлений события А находится между k1 и k2.

Локальная теорема Лапласа звучит так: если n — велико, а р — отлично от 0 и 1, то

Интегральная теорема Лапласа звучит так: если n — велико, а р — отлично от 0 и 1, то

Функции Гаусса и Лапласа обладают свойствами, которые пригодятся, чтобы правильно пользоваться таблицей значений этих функций:

Теоремы Лапласа дают удовлетворительное приближение при npq ≥ 9. Причем чем ближе значения q, p к 0,5, тем точнее данные формулы. При маленьких или больших значениях вероятности (близких к 0 или 1) формула дает большую погрешность по сравнению с исходной формулой Бернулли.